MINNEAPOLIS, MN.-

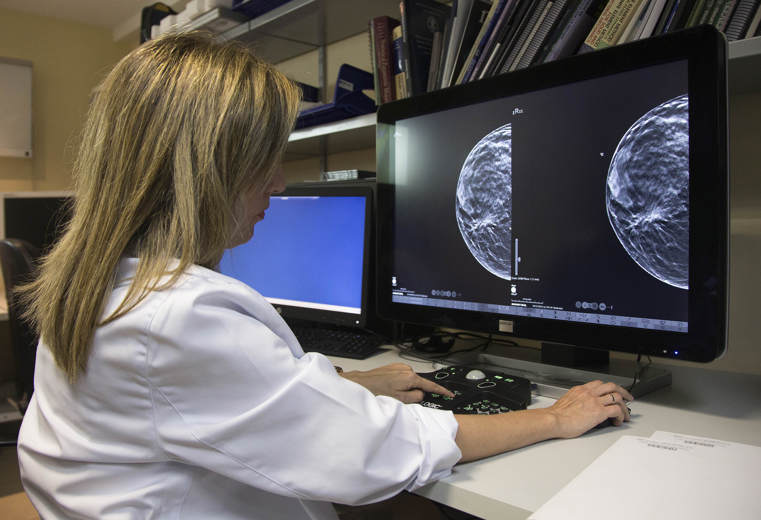

Factores como la edad y el grupo racial influyen en los resultados interpretados por un algoritmo de inteligencia artificial, revela un estudio que publica este martes la revista ‘Radiology’.

La revista de la Sociedad Radiológica de América del Norte indicó que el estudio analizó casi 5.000 mamogramas interpretadas por un algoritmo de inteligencia artificial (IA) aprobado por la Administración de Alimentos y Medicamentos (FDA, en inglés).

“La IA se ha convertido en un recurso para que los radiólogos mejoren su eficiencia y el acierto en la lectura de los exámenes con mamograma al tiempo que mitiga el cansancio de los lectores”, señaló Derek Nguyen, profesor en la Universidad Duke, de Durham, Carolina del Norte.

“Sin embargo” agregó Nguyen, “no se ha estudiado bien el impacto que tienen las características de las pacientes en el desempeño de la inteligencia artificial”.

Los investigadores identificaron pacientes con exámenes por tomosíntesis digital de mama con resultados negativos, es decir sin evidencias de cáncer, realizados en el Centro Médico de la Universidad Duke entre 2016 y 2019.

A todas las pacientes se les hizo seguimiento por dos años después del mamograma y a ninguna se le diagnosticó un tumor de mama maligno.

De este grupo los investigadores seleccionaron a 4.855 pacientes con una edad media de 54 años, con un 27 % de blancas, 26 % de negras, 28 % de asiáticas y 19 % de latinas.

Luego usaron un algoritmo disponible comercialmente para la interpretación de cada examen en este grupo a fin de evaluar si el desempeño del algoritmo de IA era uniforme en todos los grupos por edad, tipo de densidad del seno y las diferencias raciales y étnicas.

Dado que todos los mamogramas habían dado resultado negativo de la presencia de cáncer, cualquiera de ellos señalado como sospechoso por el algoritmo se consideró un resultado positivo falso.

Estos positivos falsos fueron significativamente más probables en las pacientes afroamericanas, y menos probables en las pacientes hispanas y asiáticas en la comparación con las pacientes blancas.

“Este estudio es importante porque demuestra que cualquier ‘software’ de inteligencia artificial que compre una institución de cuidado de la salud puede no desempeñase igualmente con todas las pacientes, los grupos raciales y étnicos y la densidad del seno”, dijo Nguyen.

“Las actualizaciones de los programas de IA deberían enfocarse en asegurar la diversidad demográfica”, añadió.